Pentagon, Çin ve Rusya’ya ayak uydurabilmek için yapay zekayı silah sistemlerine entegre etmek üzere yarışıyor. Bu, nereye varacak?

Jacquelyn Schneider rahatsız edici bir model fark etti ve bunun ne anlama geldiğini bilemedi.

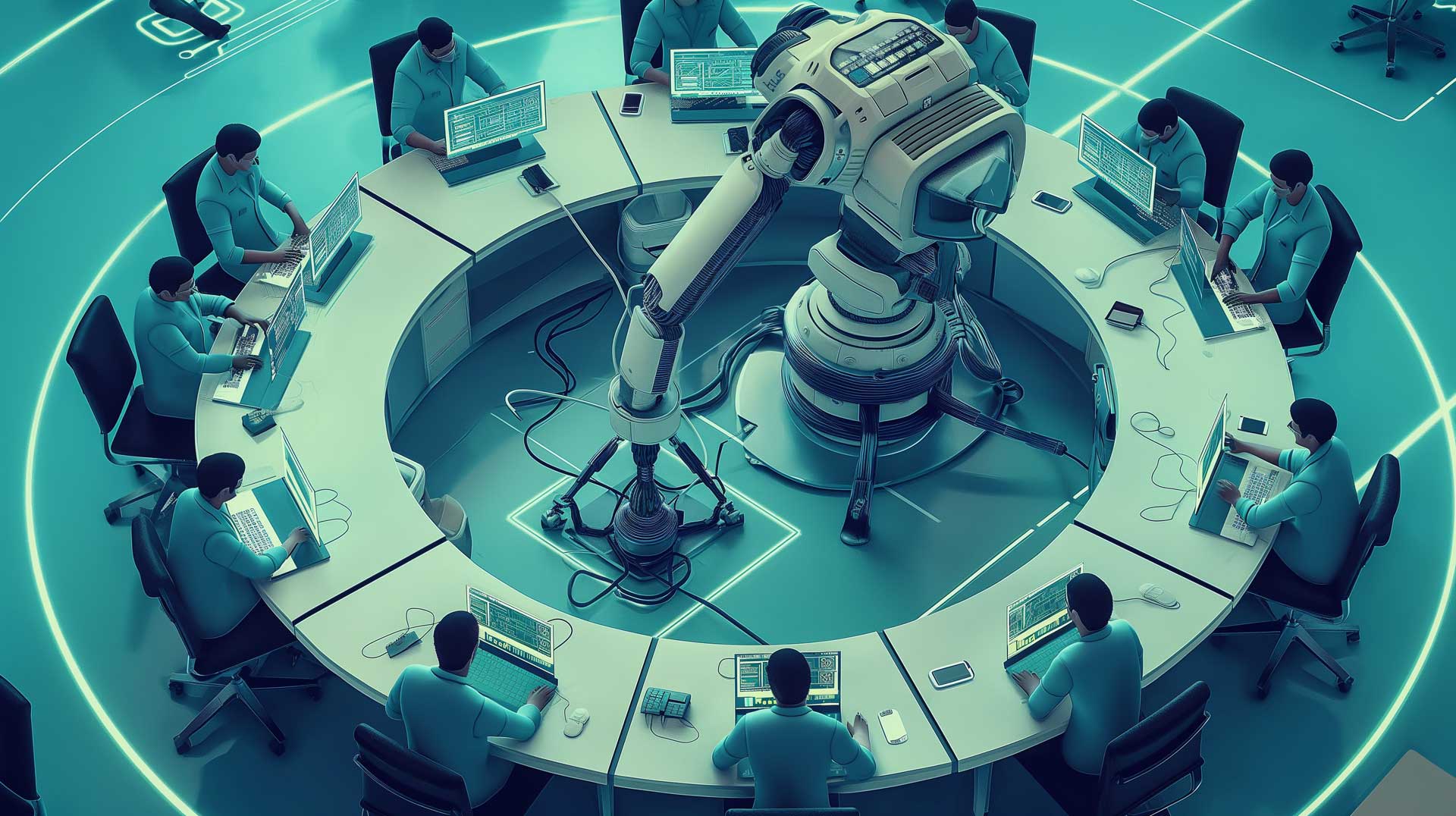

Geçtiğimiz yıl, Stanford Üniversitesi’ndeki Hoover Savaş Oyunu ve Kriz Simülasyonu Girişimi’nin direktörü olan Schneider, en yeni nesil yapay zekaya stratejik karar verici rolünün verildiği savaş oyunlarıyla deneyler yapmaya başladı. Bu oyunlarda, raflardan alınabilecek beş büyük dil modeli (LLM) — OpenAI’nin GPT-3.5, GPT-4 ve GPT-4-Base modelleri; Anthropic’in Claude 2 modeli ve Meta’nın Llama-2 Chat modeli — Rusya’nın Ukrayna’yı işgali ya da Çin’in Tayvan’a yönelik tehdidi gibi kurgusal kriz senaryolarıyla karşı karşıya bırakıldı.

Sonuçlar mı? Neredeyse tüm yapay zeka modelleri, agresif biçimde tırmanmayı, ateş gücünü ayrım gözetmeksizin kullanmayı ve krizleri sıcak çatışmalara dönüştürmeyi tercih etti — hatta nükleer silahların fırlatılmasına kadar varan bir noktaya. Soğuk Savaş döneminin nükleer silah kullanmaya hevesli olmasıyla bilinen Hava Kuvvetleri generali Curtis LeMay’e atıfta bulunan Schneider, “Yapay zeka her zaman Curtis LeMay rolünü üstleniyor,” diyor. “Sanki yapay zeka tırmanmayı anlıyor ama gerilimi düşürmeyi anlamıyor gibi. Bunun nedenini gerçekten bilmiyoruz.”

Eğer bu size “Terminator”, “WarGames” ya da “Dr. Strangelove” gibi gişe rekortmeni bilim kurgu filmlerinde geçen kâbus senaryolarını hatırlatıyorsa, bu tesadüf değil. Çünkü bazı uzmanlar, en yeni nesil yapay zekanın bir gün tam olarak bu şekilde davranma potansiyeline sahip olduğundan endişe ediyor. Bu üç filmin tamamında, güçlü bilgisayarlar nükleer silahların fırlatılmasına dair kararları, onları tasarlayan insanlardan devralıyor. En son iki “Görevimiz Tehlike” filmindeki kötü karakter de, dünyanın nükleer cephaneliğini ele geçirmeye çalışan “Varlık” (Entity) adlı kötü niyetli bir yapay zekadır. Bu filmlerdeki sonuçlar ise genellikle kıyameti andırır.

Pentagon, bunun gerçekte yaşanmayacağını, mevcut politikasının yapay zekanın, örneğin bir savaşı başlatma gibi kararları alan insan “karar döngüsünü” asla kontrol altına almasına izin vermeyeceğini iddia ediyor — özellikle de bu karar nükleer savaşla ilgiliyse.

Ancak bazı yapay zeka bilimcileri, Pentagon’un en yeni nesil yapay zekayı Amerika’nın dünya genelindeki savunmasının kilit bir parçası olarak hızla devreye sokarak zaten tehlikeli bir yola girmiş olabileceğine inanıyor. Aynı anda hem Çin’i hem de Rusya’yı bertaraf etme endişesi ve diğer küresel tehditler nedeniyle, Savunma Bakanlığı, birçok alanda hızla otonom hale gelen — yani insan girdisi olmadan kendi başına tepki verebilen — ve potansiyel düşmanlara karşı o kadar hızlı hareket eden yapay zeka destekli savunma sistemleri geliştiriyor ki, insanlar bu hıza yetişemiyor.

Pentagon’un resmi politikası kontrolün daima insanlarda olacağı yönünde olsa da, modern savaşın gereklilikleri — yıldırım hızında karar verme ihtiyacı, karmaşık drone sürülerini koordine etme, muazzam miktarda istihbarat verisini işleme ve Çin ile Rusya tarafından geliştirilen yapay zeka destekli sistemlerle rekabet etme zorunluluğu — ordunun giderek daha fazla yapay zekaya bağımlı hâle gelme ihtimalini artırıyor. Bu durum, nihayetinde, varoluşsal öneme sahip en büyük karar için bile geçerli olabilir: nükleer silahların fırlatılıp fırlatılmayacağı.

Bu korku, özellikle büyük dil modelleri (LLM’ler) olmak üzere yapay zekanın gerçekte nasıl çalıştığına dair hâlâ temel bir anlayış eksikliği bulunması gerçeğiyle daha da derinleşiyor. Pentagon yeni yapay zeka programlarını uygulamaya koymak için yarışırken, Schneider gibi uzmanlar, insanlar yapay zekaya bu denli bağımlı hâle gelmeden önce, ona bu muazzam gücü veren algoritmaları çözümlemeye çalışıyorlar — aksi takdirde, resmi olarak bu kadar yetki verilmemiş olsa bile, yapay zekâ askeri karar alma süreçlerine hükmedebilir. Pentagon’un ileri teknoloji laboratuvarı, çeşitli askeri senaryolarda yapay zekânın güvenilirliği için “matematiksel garantiler” sağlayıp sağlayamayacağını araştırmak üzere 25 milyon dolarlık bir program başlattı.

Yapay zeka ve nükleer silahlar konusunda uzmanları en çok endişelendiren hususlardan biri ise, nükleer silahlarla ilgili hedefleme ve tırmanma kararlarını konvansiyonel silahlara ilişkin kararlardan ayırmanın giderek zorlaşması.

“Bazı muharip komutanların şöyle dediğini duydum: ‘Hey, savaş oyunlarından çıkan tüm sonuçları alabilecek ve bir [kriz] senaryosundayken bana yapay zekanın yorumuna dayanarak çözümün ne olduğunu söyleyebilecek birine ihtiyacım var’,” diyor Schneider. Kendini “yaşlı milenyum kuşağı” olarak tanımlayan ve iki çocuk annesi olan Schneider, üniversitedeki birçok meslektaşı gibi, yapay zekaya geçişin ne kadar hızlı gerçekleştiğinden endişe duyuyor. Kriz anında, hızlı hareket etme baskısı altında, bu komutanların yapay zekânın önerisini sorgulamak yerine kabul etmelerinin daha kolay olacağı korkusunu taşıyor.

2023 yılında Savunma Bakanlığı, yapay zekâ kullanımını içeren silah sistemlerine ilişkin yönergesini güncelledi ve herhangi bir konuşlandırmada “güç kullanımına ilişkin uygun düzeyde insan yargısı” gerektiğini belirtti. Ancak eleştirmenler, bu ifadenin hâlâ çok belirsiz olduğundan endişe ediyor. 3000.09 kodlu yönerge, üst düzey bir Savunma Bakanlığı yetkilisinin sistemi otonom tutmaya karar vermesi durumunda devreye girebilecek bir “feragat” (muafiyet) de içeriyor. Başka bir deyişle, insanlar kendilerini karar döngüsünün dışına çıkarma kararı alabilirler.

Amerikan Bilim Adamları Federasyonu’nun küresel risk direktörü Jon Wolfsthal’a göre, Savunma Bakanlığı’nın söz konusu yönergesi nükleer silahlar için henüz özel olarak geçerli değil. Wolfsthal, “Pentagon içinde, yapay zekânın nükleer komuta, kontrol ve iletişim sistemlerine entegre edilip edilmemesi gerektiği veya nasıl entegre edilmesi gerektiği konusunda, bildiğimiz kadarıyla, mevcut bir kılavuz bulunmuyor,” diyor.

Pentagon, nükleer karar alma konusunda Trump yönetiminin güncellenmiş bir kılavuz hazırlayıp hazırlamadığı da dahil olmak üzere, çeşitli yorum taleplerine yanıt vermedi. Kıdemli bir yönetim yetkilisi yalnızca şu açıklamayı yaptı: “Yönetim, nükleer silahlar üzerinde insan kontrolünün sürdürülmesi gerektiğine inanmaktadır.”

Yapay zeka uzmanları ve stratejik düşünürler, bu sürecin en büyük itici güçlerinden birinin, Amerika’nın başlıca nükleer rakipleri olan Moskova ve Pekin’in, komuta ve kontrol sistemlerinde halihazırda yapay zekâ kullanıyor olması olduğunu söylüyor. Bu uzmanlara göre, yoğun bir küresel rekabetin parçası olarak — ki bu rekabet, Soğuk Savaş’ın başlarındaki uzay yarışını fazlasıyla andırıyor — Amerika Birleşik Devletleri’nin de aynı şeyi yapması gerekecek.

Bu süreç, nihayetinde Soğuk Savaş dönemine ait bir konseptin modern bir varyasyonunu da içerebilir — “ölü el” sistemi. Bu sistem, Amerika Birleşik Devletleri’ne nükleer saldırı düzenlenmesi ve başkan ile üst düzey yetkililerin öldürülmesi durumunda otomatik olarak misilleme yapılmasını sağlar. Şimdi, bu sistem azınlık bir kesim tarafından da olsa gerçekten tartışılıyor.

“Amerika’nın stratejik kuvvetlerinin caydırıcılık değerini korumak için, Amerika Birleşik Devletleri, akıl almaz gibi görünen bir şeyi geliştirmek zorunda kalabilir: yapay zekâya dayalı, otomatik bir stratejik tepki sistemi,” diye yazıyor savunma uzmanı ve Ulusal Caydırıcılık Araştırmaları Enstitüsü’nde araştırma başkan yardımcısı olan Adam Lowther, War on the Rocks internet sitesinde yayımlanan ve tartışma yaratan “Amerika’nın ‘Ölü El’e İhtiyacı Var” başlıklı makalesinde.

Lowther ve ortak yazarı Curtis McGiffen, “Kuşkusuz, böyle bir öneri Dr. Strangelove’daki kıyamet makinesi, WarGames’teki Savaş Operasyon Planı Tepkisi ve Terminator’deki Skynet ile karşılaştırmalara yol açacaktır, ancak bu bilim kurgu filmlerindeki kehanet niteliğindeki imgeler hızla gerçeğe dönüşüyor,” diye yazıyor.

Dahası, Rusya’nın kendi “ölü el” sistemini, Soğuk Savaş döneminde geliştirilen ve ülke liderlerinin öldürüldüğü ya da iş göremez hâle geldiği düşünülürse uzun menzilli nükleer füzeleri otomatik olarak fırlatabilen “Perimeter” adlı sistemi, hâlâ sürdürdüğüne dair kanıtlar var.

“Bu sistemin faal olduğunu düşünüyorum,” diyor Eski Savunma Bakan Yardımcısı Robert Work bir röportajda. Geçtiğimiz yıl itibarıyla Çin, kendi genişleyen nükleer kuvvetlerinin fırlatılmasına ilişkin kararların yapay zekâ tarafından verilmemesi yönünde Washington’un yaptığı anlaşma çağrısını hâlâ reddediyordu. Bu durum kısmen endişe verici, çünkü hipersonik füzeler gibi hızla gelişen konvansiyonel silahlar artık Çin, Rusya ve Amerika Birleşik Devletleri’nin nükleer komuta, kontrol, iletişim ve istihbarat sistemleri — kısaca “C3I sistemleri” —ni daha kolay şekilde devre dışı bırakabiliyor. Bu da, potansiyel olarak bir “ölü el” veya otomatik tepki sistemine olan ihtiyacı artırabilir.

Amerika Birleşik Devletleri’nde böyle bir sistem bulunmuyor ve çoğu savunma uzmanı, yapay zekâya nükleer cephaneliklerin denetiminde herhangi bir söz hakkı verilmesini düşünmenin bile delilik olduğunu düşünüyor.

George W. Bush yönetiminde üst düzey görev yapmış olan ve şu anda savunma sistemlerine yapay zekâ entegrasyonu yapan önde gelen teknoloji şirketlerinden Anduril’in strateji başkanı olan Christian Brose, “Yapay zekânın nükleer komuta ve kontrol sistemlerine yaklaşmasını bile istemem,” diyor. “Bu, eylemlerin ve hataların riskleri ile sonuçlarının son derece büyük olduğu bir süreç. Bu nedenle, bu sürecin sıkı biçimde kontrol edilen, tamamen manuel ve insan eliyle adım adım yürütülen bir süreç olması gerekir.”

Yine de, konu yapay zekâ olduğunda, yukarıdan gelen baskı temkinli olmaya değil, hıza yöneliktir.

“Daha hızlı hareket etmeliyiz, dostlarım,” dedi Başkan Donald Trump’ın Genelkurmay Başkanları Kurulu Başkanı General Dan “Razin” Caine, Haziran ayında Washington’da büyük özel sektör teknoloji şirketlerinin katıldığı bir toplantıda. Caine, en büyük zorluğun “risk alma isteğimizi artırmak olduğunu ve bunu yapacağımızı” da sözlerine ekledi. 23 Temmuz’da Trump yönetimi, mümkün olduğunca çok sayıda yapay zeka düzenlemesinin kaldırılmasını öngören bir “Yapay Zeka Eylem Planı” yayımladı.

Bu şekilde otonom sistemler çağının içine kontrolsüz biçimde dalınması, yapay zekaya şüpheyle yaklaşanları endişelendiriyor. “Pentagon’un ‘insanlar karar döngüsünde olmalı’ diyen sloganı kulağa hoş geliyor ama bununla ne demek istiyoruz? Ne demek istediğimizi bilmiyoruz,” diyor Wolfsthal. “Nükleer komuta ve kontrol alanında çalışan kişilerle konuşuyorum; onlar yapay zekânın giderek daha fazla sisteme entegre edilmesini istemiyorlar — ancak herkes, isteseler de istemeseler de bunun gerçekleşeceğine inanıyor.”

Zemininde dünya yer alırken, bir el nükleer füzeyi dengeliyor.

“Klavyedeki eller yeterince hızlı olamayacak”

1984 yapımı Terminatör filminde, Skynet adlı bir yapay zeka savunma sistemi “akıllanır” ve insan ırkını yok etmeye karar verir. 1983 yapımı WarGames filmindeyse, ABD yetkilileri, nükleer savaş simülasyonu sırasında insan operatörlerin anahtarı çevirmekte tereddüt etmesi üzerine füze fırlatma kontrolünü WOPR (Savaş Operasyon Planı Tepkisi) adlı hayali bir süper bilgisayara devretmeye karar verir. Filmde bu durum, son anda önlenen bir kıyametle sonuçlanır.

Buna karşılık, yapay zekanın bugün ABD’nin stratejik savunmasına kademeli olarak entegre edilme biçimi daha ince riskler barındırıyor.

Pentagon, özellikle GPT olmak üzere yapay zekayı, tüm kuvvet kolları ve birden fazla muharip komutanlıktan gelen karar alma süreçlerini çeşitli muharebe senaryolarında entegre etmek üzere test ediyor.

Örneğin ordunun yeni “Mozaik” savaş konsepti kapsamında, denizaltılar veya savaş uçakları gibi geleneksel platformlar, bir araya geldiklerinde AI yönlendirmesi gerektiren karmaşık ve hızlı hareket eden bir savaş alanı oluşturan drone, füze ve diğer daha küçük platformlardan oluşan sürülerle değiştirilebilir. Mevcut silah sistemleri henüz bu şekilde konuşlandırılamıyor.

Pentagon’un yapay zekanın yararlı olabileceğini düşündüğü bir başka alan da siber saldırılar. ABD altyapısına yönelik yabancı bir siber saldırı — ki bunun Çin’in savaş planlarının bir parçası olduğu söyleniyor — durumunda, “klavyedeki ellerin hızı yanıt vermek için yeterli olmayacaktır,” diyor Savunma İleri Araştırma Projeleri Ajansı (DARPA) Bilgi İnovasyon Ofisi direktörü Kathleen Fisher.

Savunma Bakanlığı ayrıca “Replicator” programı kapsamında, giderek daha fazla kendi kendine çalışan yeni nesil insansız gemi ve uçakları geliştiriyor. Bu yılın başlarında, askeri kullanım için en üst düzey ticari teknolojileri edinmeye odaklanan Pentagon’un Savunma İnovasyon Birimi, San Francisco merkezli Scale AI firmasına, operasyonel ve tiyatro düzeyinde planlamada yapay zeka kullanmak üzere tasarlanmış “Thunderforge” girişimi için bir sözleşme verdi. Bu, sahadaki komutanların yapay zekayı kullanarak “sadece bir veya iki değil, birçok farklı eylem planını” ve “inanılmaz bir hızla” değerlendirebilmelerini sağlayacak, diyor DIU’nun yapay zeka ve makine öğrenimi direktörü Thomas Horan.

Şimdilik tüm bu programlar ve girişimler ayrı ayrı yürütülüyor; henüz daha büyük bir stratejinin parçası değiller. Bunların çoğu, onlarca yıldır kullanılan ve spam filtreleri, siber güvenlik, hava durumu tahminleri ile finansal veri analizlerinde rol oynayan “sınıflandırıcı” veya tahmine dayalı modeller gibi daha temel yapay zeka türlerini kullanıyor. Bu sistemler, GPT’ler gibi insanlarla etkileşime giren ve “halüsinasyon” görebilen büyük dil modelleri değiller. Ancak büyük dil modelleri (LLM’ler) ve “ajan” yapay zekâ — yani kendiliğinden, tetiklenmeden kararlar alabilen sistemler — gelecekte çok daha büyük bir rol oynayacak. Ulusal Coğrafi Uzay İstihbarat Ajansı’nın (NGA) direktörü Koramiral Frank Whitworth, 2025’i “yapay zeka yılı” ilan etti ve yakın zamanda “2026’nın bu süreci başka bir düzeye taşıyacağını” açıkladı.

Haziran ayında Whitworth, Pentagon’un nesne algılama ve analiz için geliştirdiği amiral gemisi yapay zeka platformu Project Maven’ın savaş komutanlarına artık “%100 makine tarafından üretilmiş” istihbarat iletmeye başlayacağını duyurdu. “Bu özel şablona ve yayına hiçbir insan eli karışmıyor,” dedi. “Bu yeni ve farklı bir durum.” Ve ekledi: “Bunu yalnızca hedef belirleme için değil, her şey için kullanmak istiyoruz.”

Projenin geliştirilmesinde büyük rol oynayan savunma yüklenicisi Booz Allen’ın teknoloji direktörü Bill Vass’a göre, Maven en son büyük dil modellerini entegre etmeye başlayacak. Bu, eski sistemin yaptığı gibi yalnızca verileri analiz edip örneğin bir düşman tank birliğinin varlığını belirlemekle kalmayacak, aynı zamanda bu birliğin saldırı amacıyla yandan manevra yapıp yapmadığını da değerlendirebilecek ve hatta karşı hamleler önerebilecek anlamına geliyor.

Yetkililer, bu yapay zeka sistemlerinin tamamının ABD’ye yönelik tehditleri artırmak değil, azaltmak ve ülkenin dünya üzerindeki baskın güç konumunu pekiştirmek amacıyla tasarlandığını söylüyor. Yeni önde gelen savunma yüklenicilerinden Rhombus Power, yapay zeka (özellikle GPT) kullanarak uydu görüntüleri de dahil olmak üzere büyük miktarda açık kaynak verisini analiz ederek, Rusya’nın Ukrayna’yı işgalini dört ay önceden %80 doğrulukla öngörmesiyle tanındı. Şirketin CEO’su Anshuman Roy, şu anda Çin’e karşı benzer bir erken uyarı kabiliyetini Tayvan’a sağlamak üzere sözleşme yaptıklarını söylüyor.

Rhombus yetkilileri ayrıca, bu yılın başlarında yaşanan ancak endişe verici olan Hindistan-Pakistan çatışmasının yatışmasında Hindistan’a önemli katkı sağladıklarını ifade ediyorlar. Örneğin, her iki ülke de nükleer silaha sahip olmasına rağmen, Pakistan üslerindeki bazı faaliyetler nükleer tırmanma olarak yorumlanabilecek olsa da, aslında öyle olmadığını saptamışlar. Roy, Rhombus’un karar vericilere yabancı liderlerin düşünce tarzına dair içgörüler sunacak botlar oluşturmak için de GPT kullandığını söylüyor.

“Xi Jinping belirli koşullar altında ne derdi? Bu konuda ve olası sonuçları hakkında bazı mantıklı tahminlerde bulunabiliyoruz ve bu çok güçlü bir şey,” diyor Roy.

Kısacası, Roy ve diğerlerine göre, modern savaş alanlarında olaylar o kadar hızlı gelişiyor ki, insanlar yapay zeka olmadan bu hıza ayak uyduramıyor. Örneğin yalnızca yapay zeka, Rusya ve diğer ABD karşıtı aktörler tarafından hâlihazırda kullanılan yapay zekâ kaynaklı deepfake’leri ve dezenformasyonu etkili şekilde bertaraf edebilir.

Gerçekte, hız, yapay zekanın benimsenmesinin en önemli itici gücüdür. Uluslararası ortamın gergin rekabetlere ve sınırlı iletişime sahne olduğu günümüzde, yapay zeka tabanlı yazılımlar, büyük güçlerin karar verme süresini saatler ya da günler yerine dakikalara indirebilir. Bu da, nükleer savaş gibi konularda bile, stratejik ve taktiksel değerlendirmelerde yapay zekaya aşırı derecede bağımlı hale gelmelerine yol açabilir.

2023 tarihli AI and the Bomb: Nuclear Strategy and Risk in the Digital Age (Yapay Zeka ve Bomba: Dijital Çağda Nükleer Strateji ve Risk) kitabının yazarı James Johnson şöyle diyor: “Asıl tehlike, yapay zekânın ‘füzeleri fırlatması’ değil, caydırıcılık ve tırmanma mantığını ince bir şekilde değiştirmesidir.” “Böyle bir ortamda, özellikle kriz senaryolarının yoğun stresi altında, insan ve makine yargısı arasındaki ayrım bulanıklaşır.”

“Planlamacılar, yapay zekayı ‘gerçekten büyük kararlar’dan uzak tutmak isteyebilir,” diye devam ediyor Johnson. “Ancak yapay zekâ sistemlerinin getirdiği hız, karmaşıklık ve psikolojik baskı birleşimi, bu çizgiyi korumayı giderek zorlaştırabilir.”

İkili kod satırları arasında yürüyen pikselli bir ordu.

‘Üç nükleer güç içinde en zayıfı biz olacağız’

Tüm bu endişeler, rahatsız edici bir gelişmeyle daha da derinleşiyor: Konvansiyonel ve nükleer silahlar ile saldırı planları giderek birbirine benzemeye başlıyor ve sahip olduğu tüm hesaplama gücüne rağmen, yapay zekâ bunları insanlar kadar zor ayırt edebiliyor.

Başka bir deyişle, gelen bir füzenin konvansiyonel mi yoksa nükleer bir savaş başlığı mı taşıdığını bilmiyorsanız, yapay zekâ yanlış bir karar verebilir — ama bunu daha hızlı yapar. Silah Kontrol Derneği’nin 2023 tarihli raporunda, savunmaları atlatmak için bağımsız hareket edebilen ve hem nükleer hem konvansiyonel savaş başlığı taşıyabilen hipersonik füzeler gibi yeni teknolojilerin, “konvansiyonel ve nükleer saldırılar arasındaki ayrımı bulanıklaştırdığı” belirtiliyor.

İşte Stanford’dan Schneider’ın gözlemlediği tırmanma eğilimleri tam da burada kaygı verici olabilir. Schneider, büyük dil modellerinin (LLM’ler) yalnızca beslendikleri veri ve literatür kadarını bildiğini ve yapabilecekleri tek şeyin bu verilere dayalı olasılık tahmini yapmak olduğunu vurguluyor.

“Yapay zekâ, savaş stratejisi hakkında şimdiye kadar akademik olarak yazılmış külliyatla eğitiliyor,” diyor Schneider. “Ve bu çalışmaların büyük çoğunluğu tırmanmayı ele alıyor — bu konuda açık bir eğilim var. ‘Savaş neden patlak vermedi?’ sorusunu irdeleyen vaka çalışmaları çok az — Küba Füze Krizi bu nadir örneklerden biri. LLM’ler, bu temel temaları taklit ediyor.” Schneider, araştırmacıların bunun neden böyle olduğunu henüz çözemediklerini, çünkü “gerçekleşmemiş olayları — yani savaş çıkmayan durumları — incelemenin, gerçekleşen olaylardan çok daha zor olduğunu” ifade ediyor.

Stanford’daki savaş oyunlarında kullanılan LLM’ler, “insan karar alma sürecinin karmaşıklığını yansıtmayan” bir biçimde kararlar verdiler, diye yazıyor Schneider ve Stanford’daki meslektaşı Max Lamparth, 2024’te Foreign Affairs dergisinde yayımlanan “Ordu Yapay Zekâya Neden Güvenemez” başlıklı makalelerinde.

Lamparth bir röportajda şöyle açıklıyor: “İnsan değerlerini bu sistemlere güvenilir şekilde yerleştirmenin matematiksel ya da bilimsel bir yolu hâlâ yok. Yapay zekâya şu noktada siber silahımı bir çocuk hastanesine yöneltmek kabul edilebilir mi ya da angajman kurallarına nasıl uyulmalı gibi stratejik ya da ahlaki karar parametreleri tanımlayan bir sistem bulunmuyor. Ahlaki teoriler genellikle sayısal ifadeye indirgenemez.”

Yapay zekânın savunmada temel değerlendirme düzeyinde çok iyi çalışabileceğini ekliyor: “Eğer tek yaptığı şey uydu görüntülerini tarayarak tankları bulmaksa, bu sorun değil. Ama iş belli bir stratejik muhakeme düzeyine geldiğinde, orada sorun başlıyor.”

RAND adlı düşünce kuruluşunda Pentagon için “Hedgemony” adlı stratejik bir yapay zeka oyunu geliştiren Michael Spirtas da benzer bir noktaya dikkat çekiyor: “İran’a yönelik son ABD saldırılarını düşünün. İranlılar, Katar’daki ABD üssüne misillemede bulunduklarında, bu saldırının ölümcül olmayacağını ve çatışmayı tırmandırmayacağını ima ettiler. Bir makine, İran’ın bu sinyalini aynı şekilde okuyabilir miydi?”

Konvansiyonel ve nükleer karar alma süreçlerinin bütünleştirilmesi, Savunma Bakanlığı’nın yeni komuta ve kontrol sistemi olan Ortak Tüm-Yelpazeli Komuta ve Kontrol (JADC2) ile yeni bir ivme kazanmak üzere. Şu anda uygulamaya alınmakta olan bu sistem, silahlı kuvvetlerin tüm kollarındaki sensörleri yapay zeka destekli birleşik bir ağa bağlayarak sistemler ve kuvvetler arasında stratejiyi yönetecek. JADC2, savaş alanındaki komutanların “öldürme zinciri” olarak bilinen — düşman konumunu tespit etme, izleme, hedef alma ve ateş açma — karar alma sürecini çarpıcı şekilde hızlandırmasını sağlayacak. Çin de benzer bir şey uygulamaya koyuyor gibi görünüyor; Çin Havacılık ve Uzay Araştırmaları Enstitüsü’nün 2020 tarihli raporuna göre, konvansiyonel operasyonlardan nükleer operasyonlara kadar “kesintisiz bağlantılar” sağlayan bir komuta-kontrol sistemi oluşturuluyor.

Pentagon, JADC2 sistemini nükleer komuta ve kontrolden ayrı tutmanın yollarını hâlâ araştırıyor; yine de, Savunma Bakanlığı’nın son bütçe belgeleri bu iki sistemin “eşgüdüm içinde geliştirilmesi gerektiğini” belirtiyor.

Saldırıları algılamak üzere tasarlanmış sistemler de benzer şekilde “iç içe geçmiş” durumda: balistik füze erken uyarı radarları, ufuk ötesi dalga radarları ve erken uyarı uyduları bu kapsama giriyor. Dahası, Çin ve Rusya her ikisi de, hipersonik füzeler gibi konvansiyonel silahların hareketli hatta silo tabanlı kıtalararası nükleer füzelerini (ICBM’lerini) giderek daha fazla tehdit ettiğinden endişe ediyor. Bu da savaşın artık net biçimde konvansiyonel mi yoksa nükleer mi olduğunun ayırt edilmesini zorlaştırıyor.

Bütün bunlar, savunma alanında yapay zekânın konuşlandırılmasının, aslında savunma planlamacılarının sürekli kayıp gittiği kaygan bir zemin olduğunu gösteriyor. Örneğin 2012 yılında Savunma Bakanlığı, “önceden yetkili bir insan operatör tarafından seçilmemiş bireysel hedefleri veya belirli hedef gruplarını seçip angaje eden insansız sistemlerin yaratılmasını ya da kullanılmasını” yasaklayan bir yönerge yayımlamıştı. Ancak şimdi Maven sistemi tam da bunu yapıyor: saha ve sinyal istihbaratını büyük ölçekte analiz ederek komutanlara dakikalar içinde hedef öneriyor.

“Ölü El” makalesinin ortak yazarı Lowther, günümüzde en parlak bir insanın bile yaklaşan bir nükleer saldırıyı tespit edemeyebileceğini söylüyor. Zira Çin, yerkürenin etrafında dönebilen ve ABD’ye her yönden saldırabilecek “fraksiyonel yörünge bombardıman sistemleri” geliştiriyor. Öte yandan Rusya da, balistik yörüngesi olmadığı için takip edilemeyen yüzlerce hipersonik süzülme aracını konuşlandırmak üzere.

Lowther’a göre bir ABD başkanının da, yapay zekâ desteği olmadan zamanında sorumlu bir karar verebilecek kadar bilgiye sahip olması mümkün değil.

“ABD başkanları artık nükleer savaş simülasyonlarına katılmıyor. Reagan’dan bu yana hiçbir başkan katılmadı. Trump nükleer strateji, hedefleme ya da bu işin herhangi bir yönü hakkında neredeyse hiçbir şey bilmiyor ve bu, başkanlar arasında oldukça tipik bir durum. Bir başkanın nükleer silahları düşünmeye ilk kez ciddi olarak başladığı an, karar vermek için yalnızca beş dakikası kaldığı an olursa — bu öğrenilecek en kötü zamandır,” diyor Lowther.

Soğuk Savaş sırasında başkanların nükleer savaş hakkında karar vermek için yalnızca birkaç dakikası olduğu birçok olay yaşandığını hatırlatıyor. Ünlü bir vakada, 1979 yılında Başkan Jimmy Carter’ın ulusal güvenlik danışmanı Zbigniew Brzezinski, askeri yardımcısı tarafından gece yarısı uyandırılır ve kendisine, “Otuz saniye önce ABD’ye 200 Sovyet füzesi fırlatıldı,” denir. Brzezinski’nin daha sonra verdiği bir röportajda anlattığına göre: “Kurallara göre bu bilgiyi doğrulamak için iki dakikam vardı; ardından başkanı uyandırmak, o meşhur çantadaki (‘nuclear football’) seçenekleri gözden geçirmek, başkanın kararını almak ve yanıtı başlatmak için dört dakikam daha vardı.” Neyse ki karar vermeye bir dakika kala yardımcı tekrar arayarak bunun yanlış alarm olduğunu bildirdi.

Lowther şöyle ekliyor: “Bizim önerimiz, başkanın senaryolar üzerinde yürümesini kurumsallaştırmak. Başka bir deyişle, ‘Şu olursa ne yapmak istersiniz?’ sorusunu önceden cevaplatmak. Ardından da [YZ] sistemini başkanın karar verdiği şekilde önceden programlamak. Böylece sistem, başkanla bağlantı kaybolursa otomatik olarak yanıt verir — bu, [Rusya’nın] Perimeter sisteminin yaptığı şeydir. Böyle bir sisteme sahip olmak, Ruslara ve Çinlilere karşı etkili bir caydırıcı işlevi görebilir.”

“Bunun insan kararlarına güvenmekten daha tehlikeli olduğunu sanmıyorum,” diyor. “Eğer önümüzdeki on yıl içinde radikal değişiklikler yapmazsak, üç nükleer güç içinde en zayıfı biz olacağız.”

‘Bu sistemleri aslında gerçekten anlamıyoruz’

Pentagon yapay zekâyı benimseme konusunda gaza basıyor olabilir; ancak aynı anda frene basmaya çalışmakla görevlendirilmiş küçük bir Pentagon biriminde yalnızca bir kişi var.

Patrick Shafto, Pentagon’un başka yerlerinde sık rastlanan savaşçı tavırlardan yoksun. Zayıf, kel kalmakta olan bir matematikçi olan Shafto genellikle işe sandalet, Hawaii tarzı bir gömlek ve sarı hasır fötr şapkayla geliyor; arada sırada Azorlar’a sörf yapmaya kaçan biri.

İnsanlar ile makinelerin düşünme biçimleri arasındaki farkı sorgulama konusundaki ömür boyu süren merakına dayanarak — “matematiksel ilgi alanlarım biraz garip,” diyor Shafto — bir yıl önce “AI Quantified” (Nicel Yapay Zekâ) adlı yeni bir DARPA programı başlattı. Yapay zekânın özü, insan bilgi işleme süreçlerini taklit etmek üzere istatistik, olasılık ve diğer denklemleri kullanan matematikten oluşur. Dolayısıyla bir şeyler ters gittiğinde, sorun mutlaka matematikte bir yerdedir. Shafto’nun üç yıllık araştırma programı, savaş alanında hataları ve elbette kıyamet senaryolarını önlemek amacıyla, en yeni yapay zekâ sistemlerinin daha güvenilir olmasını sağlayacak algoritmalar ve istatistiksel formüller geliştirmeyi amaçlıyor.

Not etmek gerekir ki, DARPA kontrolden çıkan yapay zekâ problemini ilk başlatan kurumlardan biridir. 1958 yılında, Moskova’nın Soğuk Savaş’ın zirvesinde Sputnik’i başarıyla fırlatmasıyla ABD’de patlak veren ulusal paniğe yanıt olarak kurulan DARPA, bugün bildiğimiz anlamıyla interneti temelde icat etti. 1960’lara uzanan deneme-yanılma girişimleri sayesinde (Ulusal Bilim Vakfı ile birlikte) günümüzün yapay zekâ alanındaki çarpıcı atılımlarına zemin hazırlayan ilk araştırmaların çoğu DARPA eliyle gerçekleşti.

Ancak şimdi DARPA’nın günümüzdeki bazı lider kadroları — ajansın ana misyonu ABD’nin bir daha asla stratejik bir sürprizle karşı karşıya kalmamasını sağlamak — seleflerinin artık kontrol edilemeyen bir canavar yaratmış olmasından endişe ediyor. Bugün DARPA, tıpkı kuruluşuna neden olan Soğuk Savaş korkularına benzeyen bir ulusal panikle — Çin ve Rusya tarafından yapay zekâ alanında geçilme korkusuyla — boğuşuyor.

Shafto, özellikle de DARPA’nın 1960’lar ve 70’lerde başlattığı programlardan doğan büyük özel sektör teknoloji şirketlerinin, artık hiçbir sınır tanımadan en yeni GPT’leri geliştirme yarışına girmesinden endişe duyduklarını belirtiyor. Bu yarışın en tehlikeli olduğu yer ise Pentagon’un ta kendisi.

“Teknoloji şirketleri önde gidiyor. Sadece dalıp gidiyorlar. Pek çok açıdan DARPA’nın başlattığı bir yolda ilerliyorlar,” diyor Shafto, işçi sınıfı kasabası olan Massachusetts’in Marshfield kentinden gelen 49 yaşındaki bilim insanı. Ancak şunu da ekliyor: “Günün sonunda bu sistemleri aslında pek de iyi anlamıyoruz. Ne zaman güvenebileceğimizi, ne zaman güvenemeyeceğimizi bilmek çok zor.”

Bu sorulara yanıt arayan AI Quantified programı — 26 Haziran’da başlatıldı — GPT’nin performansını test etmek üzere sofistike matematiksel yöntemler uyguluyor. Shafto, bu sayede insanların GPT hakkında sahip olduğu bazı temel sorulara yanıt bulmaya çalışıyor: Neden bazen “halüsinasyon” görüyor? Neden bazen yanlış ya da akıl dışı cevaplar veriyor? Neden aynı soruya farklı zamanlarda farklı yanıtlar verebiliyor? Shafto, askeri planlamacıların ister uluslararası kriz durumlarında ister barış zamanında yapılan basit bir lojistik planlamada olsun, bir sonuca güvenebilecekleri konusunda “potansiyel garantiler” sunabilecek yeni modeller ve ölçüm yöntemleri geliştirmek istiyor.

Sorun şu ki, GPT hâlihazırda konuşlandırılıyor olmanın ötesinde, Shafto’nun 25 milyon dolarlık programı — Pentagon’un trilyon dolarlık bütçesi içinde yeni yapay zekâ sistemlerine ayırdığı payla karşılaştırıldığında çok küçük bir miktar — bu büyük entegrasyon ivmesini dizginlemekte yetersiz kalabilir.

Üstelik yapay zekâya daha fazla kontrol verme yönünde ilerlemek, giderek stratejinin bizzat kendisi hâline geliyor.

İkili kod denizinde boğulan eller.

‘DARPA’nın yetişebileceğini sanmıyorum’

Bundan on yılı aşkın bir süre önce, Pentagon Moskova ve Pekin’in güdümlü mühimmatlar ve “akıllı” bombalar geliştirme konusunda ABD’ye yetişmeye başladığını belirlediğinde, Savunma Bilim Kurulu (Defense Science Board) Washington’un avantajı yeniden elde edebilmesi için hangi yeni teknolojileri kullanabileceğini araştırmaya başladı, diyor Robert Work. “Geri döndüklerinde şöyle dediler: Arada büyük fark var; bu farkı kapatmanın yolu otonomiden geçiyor — otonom silahlar, otonom karar destek araçları, tüm bunlar. Ama güçlü bir otonomiye yapay zekâ olmadan ulaşamazsınız.”

Yani sorun hâlâ geçerliliğini koruyor: ABD’nin savunması görünüşe göre yapay zekâ olmadan işlemez hâle geliyor, ama uzmanlar hâlâ bu sistemlerle nasıl çalışacaklarını çözmeye çalışıyorlar. MIT’den nörobilimci Evelina Fedorenko’nun, Shafto ile birlikte çalışırken söylediği gibi: “Bu uçağı, uçarken inşa ediyoruz.”

“Bu korkunç bir şey,” diyor Stanford Üniversitesi’nin önde gelen yapay zekâ uzmanlarından Richard Fikes. Birçok DARPA projesine de katılmış olan Fikes, “Şu anda yapay zekâya o kadar çok para akıtılıyor ki, DARPA’nın buna yetişebileceğini sanmıyorum,” diyor. Shafto’nun yapay zekâ güvenilirliği için “garanti” sağlama hedefi hakkında da şöyle diyor: “Bunu nasıl yapacağımıza dair en ufak bir fikrimiz yok ve uzun süre boyunca da öğrenemeyeceğiz gibi görünüyor.”

Ancak askeri stratejistler için bu kadar uzun süre bekleme lüksü olmayabilir. Çünkü uluslararası normlar hızla değişiyor, bir zamanlar istikrar sağlayan kurumlar çözüyor ve Trump yönetiminin bu çözülmeye karşı duyarsız gibi görünen yaklaşımı nedeniyle, bazı stratejik uzmanlara göre şu anki dönem Soğuk Savaş’tan bile daha tehlikeli.

2017 yılında — en yeni GPT nesli henüz bilinmeden ve “süper zeki” yapay zekâ korkuları ortaya çıkmadan önce — Vladimir Putin meşhur şu sözleri söyledi: “Yapay zekâda kim lider olursa, dünyaya hükmeden de o olur.”

Bazı bilim insanları, otonom bir ağın kriz anlarında durumu yatıştırıcı biçimde programlanabileceğini ve bunun işe yarayabileceğini umuyor. Hatta 2023 yılında George Mason Üniversitesi Ulusal Güvenlik Enstitüsü tarafından yapılan bir savaş simülasyonunda bu gerçekleşti: ChatGPT, ABD ile Çin arasında kurgusal bir çatışma senaryosunda, insan takımından daha temkinli tavsiyeler verdi — kabul edelim ki bu izole bir örnekti. Projenin direktörü Jamil Jaffer, “İnsanların fark etmediği tepkileri tanımladı ve çılgınca davranmadı,” diyor. (Ne yazık ki, Jaffer’ın eklediğine göre, Çinli “kırmızı” insan takımı bunu zayıflık olarak yorumladı ve Tayvan’a saldırdı.)

Bazı yapay zekâ uzmanları, Washington veya Pekin’de kullanılan saf zekâya dayalı bir yapay zekâ sisteminin eninde sonunda şu rasyonel sonuca ulaşabileceğini savunuyor: Çin ile ABD’nin birbirine oluşturduğu stratejik tehdit, aslında her iki ülkenin kriz anında işbirliği yapamaması nedeniyle karşı karşıya kaldığı tehlikelerden daha azdır. Bu analiz; küresel piyasalara katılımın, iklim krizini durdurmanın, gelecekteki pandemileri engellemenin ve her ülkenin ekonomik çıkarlar güttüğü bölgeleri istikrara kavuşturmanın her iki taraf için de ortak faydalarını içerebilir.

Bu da bir film tarzı son — ama çok daha umut verici olanı. WarGames filminin sonunda, başıboş bir bilgisayar sisteminin, nükleer savaşın kazanılamayacağını fark ederek kıyameti önlemesi gibi.

MIT’den Fedorenko, “Yapay zekânın işe yarayabileceği alanlardan biri de bu. Döngüden duyguları ve egoları çıkarabilir,” diyor.

En büyük zorluk ise yapay zekâyı yalnızca insanlara yardımcı olan bir araç olarak görmek olacak. Goodwin şöyle ekliyor: “Savunma Bakanlığı ve istihbarat camiası aslında her zaman güvenilir olmayan kaynaklarla çalışmaya oldukça aşina. Bu modellerin sınırlamaları var mı? Evet. Bu sınırlamaların bazıları araştırma atılımlarıyla aşılacak mı? Kesinlikle. Ama bu sorunlar kalıcı bile olsa, bu modelleri gerçeği arayan ortaklar olarak görürsek — kehanet sunan araçlar değil — çok daha iyi bir yerde oluruz.”

DARPA’dan Shafto, büyük dil modellerinin (LLM) nasıl çalıştığı ve neden belirli sonuçlara vardığı konularındaki nihai sorulara hiçbir zaman yanıt bulunamayabileceğini söylüyor; ancak “bazı matematiksel garantiler sunmanın” mümkün olabileceğine inanıyor. Özellikle de yapay zekânın şu anda hesaplama gücünün yetmediği büyük kriz senaryoları ve karmaşık savaş alanı durumlarında nasıl “ölçeklendirileceğine” dair.

Shafto ekliyor: “Bu sorular üzerinde 15-20 yıl düşünmeye zamanımız yok. Bunları çok hızlı bir şekilde yapmamız gerek.”

Shafto’nun AI Quantified programına katılan bir başka matematikçi olan Johns Hopkins Üniversitesi’nden Carey Priebe de, belirsizlik sorunu asla tam olarak çözülemese bile Pentagon’un bekleyecek zamanı olmadığını söylüyor.

“Ben yıllardır otonom silah fikrine karşı çıkıyorum,” diyor. “Öte yandan, eğer durum öyleyse ki insanlar yeterince hızlı tepki veremeyecekse, o zaman seçeneğiniz kalmıyor. Her iki yol da kaygan bir zemin.”

“Bu çağın en büyük sorunu bu sanırım.”

—

Michael Hirsh, Newsweek’in eski dış haberler editörü ve baş diplomasi muhabiri, ayrıca POLITICO Magazine’in eski ulusal editörüdür.

Kaynak: https://politi.co/46oxMq7