Anfang dieses Monats gab OpenAI, das Unternehmen hinter der Entwicklung von ChatGPT, eine Partnerschaft mit Anduril, einem in Kalifornien ansässigen Waffenhersteller, zur Produktion von KI-gestützten Waffen bekannt. Das OpenAI-Anduril-System, das Ende November in Kalifornien getestet wurde, ermöglicht den Datenaustausch zwischen externen Parteien, um Entscheidungen auf dem Schlachtfeld zu treffen. Diese Entwicklung steht in direktem Einklang mit den Plänen des US-Militärs und von OpenAI, den Einsatz von künstlicher Intelligenz im Kriegsgeschehen zu normalisieren.

Das in Costa Mesa ansässige Unternehmen Anduril stellt KI-gestützte Drohnen, Raketen und Radarsysteme her. Zu diesen Systemen gehören Überwachungstürme und Sentry-Systeme, die auf US-Militärbasen, an der US-mexikanischen Grenze und entlang der britischen Küsten eingesetzt werden, um Migranten auf Booten zu erkennen. Im Rahmen eines am 3. Dezember unterzeichneten Dreijahresvertrags mit dem Pentagon wurde eine Vereinbarung getroffen, ein System zu entwickeln, das Soldaten während Angriffen KI-Lösungen bietet.

Im Januar hob OpenAI das direkte Verbot von „Aktivitäten mit hohem Risiko für körperlichen Schaden“ aus seinen Nutzungsrichtlinien auf. Zu diesen Aktivitäten gehörten „militärische und kriegerische Zwecke“ sowie die „Entwicklung von Waffen“. Nur eine Woche nach der Aufhebung dieses Verbots gab das Unternehmen eine Partnerschaft mit dem Pentagon im Bereich Cybersicherheit bekannt.

Obwohl OpenAI das Verbot der Waffenproduktion aufgehoben hat, ist der Einstieg des Unternehmens in die Kriegsindustrie ein klarer Widerspruch zu seinen eigenen Grundsätzen. Das Versprechen des Unternehmens, „sichere und nützliche KI“ zu entwickeln, wirkt angesichts der Nutzung der Technologie für tödliche Zwecke geradezu lächerlich. ChatGPT könnte schon bald in der Lage sein, Code für automatisierte Waffen zu schreiben, Bombenangriffe zu analysieren oder Invasionen und Besetzungsprozesse zu erleichtern.

Die Nutzung solcher KI-Systeme für Tod und Zerstörung sollte uns alle erschrecken. Doch dies ist keineswegs neu. Israel und die USA setzen seit Jahren künstliche Intelligenz in Palästina ein und testen sie dort. Hebron wird sogar als eine „Smart City“ der Besatzung bezeichnet, in der Bewegungssensoren, Wärmesensoren, Gesichtserkennungstechnologien und CCTV-Überwachungssysteme eingesetzt werden.

Im Zentrum dieser repressiven Überwachung steht das Blue-Wolf-System. Dieses KI-gestützte Werkzeug scannt die Gesichter von Palästinensern, die von israelischen Soldaten fotografiert werden, und sendet die Daten an eine biometrische Datenbank. Sobald das Foto hochgeladen wird, unterliegt jede Person einer farbkodierten Klassifizierung, basierend auf ihrem wahrgenommenen „Bedrohungslevel“. Diese Klassifizierung entscheidet darüber, ob ein Soldat der Person den Durchgang erlaubt oder sie festnimmt.

Laut Enthüllungen der Washington Post aus dem Jahr 2021 bezeichnen israelische Soldaten dieses System als „Facebook für Palästinenser“. Die Soldaten, die die meisten Fotos aufnehmen, werden sogar belohnt.

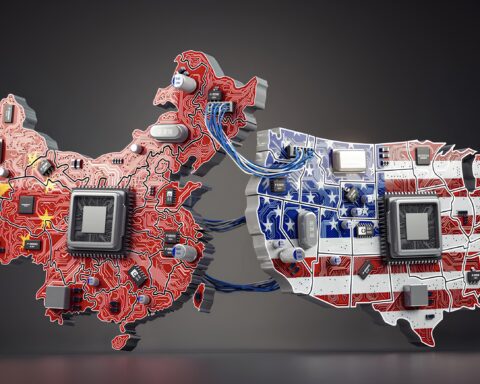

Die Kriegs-Technologie von OpenAI kommt zu einer Zeit, in der die Biden-Administration ihre Bemühungen verstärkt, Technologie zur Verwirklichung der „nationalen Sicherheitsziele“ der USA einzusetzen. In einem im Oktober veröffentlichten Memo des Weißen Hauses wurde zu einer raschen Weiterentwicklung von Künstlicher Intelligenz aufgerufen, insbesondere „im Kontext nationaler Sicherheitssysteme“. Obwohl China nicht explizit erwähnt wurde, ist klar, dass die Vorstellung eines wahrgenommenen „KI-Wettrüstens“ eine der Hauptmotivation hinter diesem Aufruf ist. Dieses Wettrüsten bezieht sich nicht nur auf Kriegswaffen, sondern auch auf die technologische Entwicklung im Allgemeinen.

Anfang dieses Monats verbot die USA den Export von HBM-Chips, einer kritischen Komponente für KI und hochentwickelte Grafikprozessoren, nach China. Der frühere Google-CEO Eric Schmidt erklärte, China sei bei KI zwei bis drei Jahre weiter als die USA. Noch zu Beginn dieses Jahres hatte Schmidt gesagt, die USA lägen vor China. Seine Aussage, dass es eine „Bedrohungs-Eskalationsmatrix“ im Bereich der KI gebe, zeigt, dass die USA diese Technologie primär als Kriegsinstrument und Mittel zur Hegemonie betrachten.

Als Antwort auf das Memo des Weißen Hauses veröffentlichte auch OpenAI eine Erklärung, in der viele ähnliche Formulierungen über „demokratische Werte“ und „nationale Sicherheit“ wiederholt wurden. Doch wie demokratisch kann es sein, wenn ein Unternehmen Technologien entwickelt, um Menschen effektiver zu bombardieren und ins Visier zu nehmen? Wem dient die gesammelte Information zur Verbesserung von Kriegstechnologie wirklich? Diese Entwicklungen zeigen deutlich, dass OpenAI mit der China-kritischen Rhetorik und den imperialistischen Zielen der Biden-Administration übereinstimmt.

Künstliche Intelligenz wird bereits genutzt, um das Töten an der US-mexikanischen Grenze, in Palästina und auf den globalen Militärbasen der USA zu erleichtern. Wir dürfen nicht vergessen, dass Technologien, die scheinbar fest in unseren Alltag integriert sind – von Suchmaschinen bis hin zu Musikplattformen – auch auf tödliche Weise eingesetzt werden können.

Über die Autoren:

Nuvpreet Kalra ist Digital Content Creator bei CODEPINK. Sie hat einen Bachelor-Abschluss in Politik und Soziologie von der Universität Cambridge sowie einen Master-Abschluss in Internetgerechtigkeit von der University of the Arts London.

Tim Biondo ist Digital Communications Manager bei CODEPINK. Er hat einen Bachelor-Abschluss in Friedens- und Konfliktstudien von der George Washington University.

Quelle: https://www.counterpunch.org/2024/12/23/openai-is-using-its-technology-to-kill/